Dlaczego HDMI-DVI zapewnia ostrzejszy obraz niż VGA?

Z całym świetnym sprzętem, jaki mamy w dzisiejszych czasach, wydaje się, że powinniśmy cieszyć się świetną jakością oglądania bez względu na wszystko, ale co, jeśli tak nie jest? Dzisiejszy post z pytaniami i odpowiedziami SuperUser ma na celu wyjaśnienie problemu zagmatwanemu czytelnikowi.

Dzisiejsza sesja pytań i odpowiedzi przychodzi do nas dzięki uprzejmości SuperUser - poddziału Stack Exchange, opartego na społecznościach grupowania witryn z pytaniami i odpowiedziami.

Zdjęcie dzięki uprzejmości lge (Flickr).

Pytanie

Aluminiowy czytnik SuperUser chce wiedzieć, dlaczego istnieje zauważalna różnica w jakości między HDMI-DVI i VGA:

Mam monitor Dell U2312HM podłączony do laptopa Dell Latitude E7440. Gdy podłączam je przez laptopa -> kabel HDMI -> adapter HDMI-DVI -> monitor (monitor nie ma gniazda HDMI), obraz jest znacznie ostrzejszy niż w przypadku podłączenia przez laptop -> adapter miniDisplayPort-VGA -> VGA kabel -> monitor.

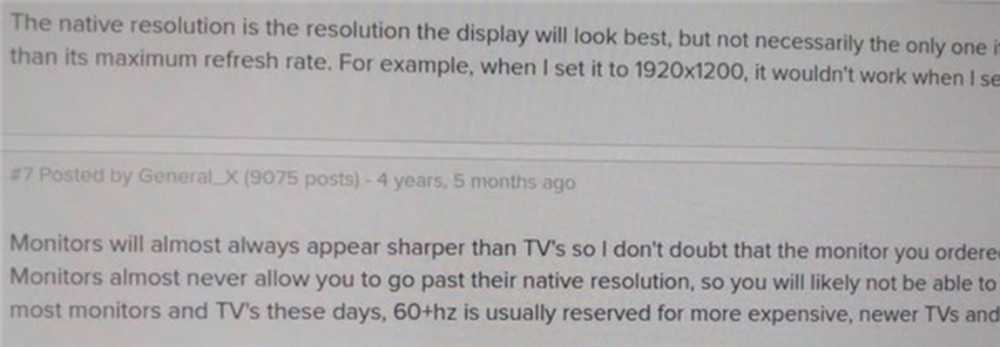

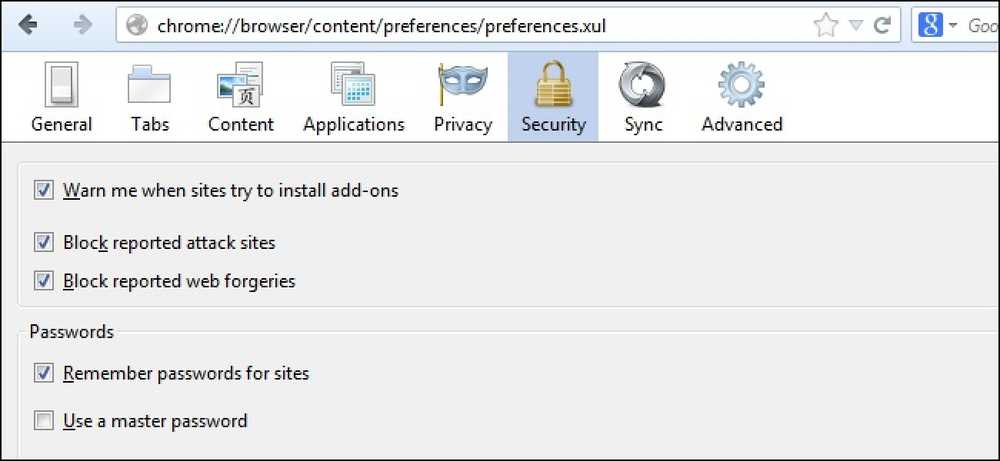

Różnica jest trudna do uchwycenia za pomocą kamery, ale zobacz moją próbę poniżej. Próbowałem grać z ustawieniami jasności, kontrastu i ostrości, ale nie mogę uzyskać tej samej jakości obrazu. Rozdzielczość wynosi 1920 * 1080, a moim systemem operacyjnym jest Ubuntu 14.04.

VGA:

HDMI:

Dlaczego jakość jest inna? Czy jest to nieodłączne od tych standardów? Czy mogę mieć wadliwy kabel VGA lub przejściówkę mDP-VGA??

Dlaczego istnieje różnica w jakości między nimi??

Odpowiedź

Współautorzy SuperUser Mate Juhasz, youngwt i Jarrod Christman mają dla nas odpowiedź. Najpierw, Mate Juhasz:

VGA jest jedynym sygnałem analogowym spośród wymienionych powyżej, więc jest to już wyjaśnienie różnicy. Korzystanie z adaptera może jeszcze bardziej pogorszyć jakość.

Dalsze czytanie: HDMI vs. DisplayPort vs. DVI vs. VGA

Następująca odpowiedź od youngwt:

Zakładając, że jasność, kontrast i ostrość są takie same w obu przypadkach, mogą istnieć dwa inne powody, dla których tekst jest ostrzejszy dzięki HDMI-DVI.

Pierwsza z nich została już stwierdzona, VGA jest analogowa, więc będzie musiała przejść przez analogową do cyfrowej konwersję wewnątrz monitora. To teoretycznie obniży jakość obrazu.

Po drugie, zakładając, że korzystasz z systemu Windows, istnieje technika o nazwie ClearType (opracowana przez firmę Microsoft), która poprawia wygląd tekstu poprzez manipulowanie subpiksem monitora LCD. VGA została opracowana z myślą o monitorach CRT, a pojęcie subpiksela nie jest takie samo. Z powodu wymogu używania ClearType na ekranie LCD oraz faktu, że standard VGA nie informuje hosta o specyfikacjach wyświetlacza, ClearType byłby wyłączony przy połączeniu VGA.

Pamiętam, że słyszałem o ClearType od jednego z jego twórców na podcastie dla This (). Developers (). Life () IIRC, ale ten artykuł Wikipedii również wspiera moją teorię. Również HDMI jest wstecznie kompatybilny z DVI, a DVI obsługuje elektroniczną identyfikację ekranu (EDID).

Ostateczna odpowiedź od Jarroda Christmana:

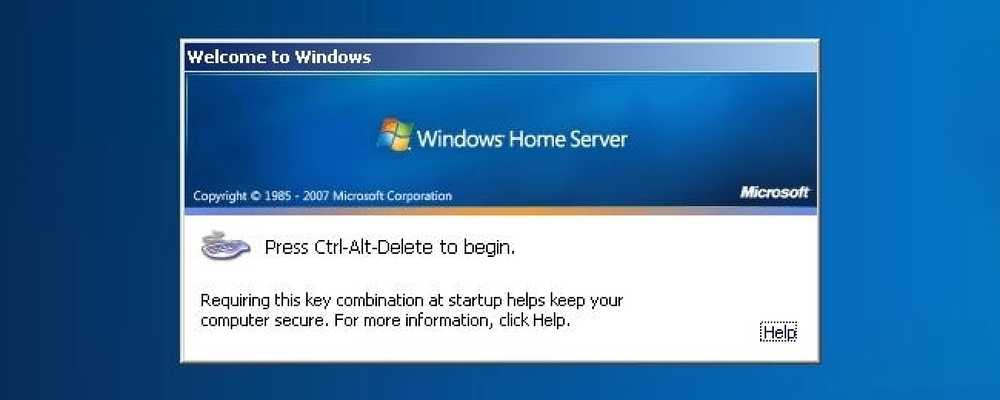

Inni robią dobre rzeczy, ale głównym powodem jest oczywiste niedopasowanie zegara i fazy. VGA jest analogowa i podlega zakłóceniom i niedopasowaniu analogowych stron wysyłających i odbierających. Normalnie można użyć takiego wzoru:

Zegar i faza

Następnie dostosuj zegar i fazę monitora, aby uzyskać najlepsze dopasowanie i najostrzejsze zdjęcie. Ponieważ jednak jest to ustawienie analogowe, zmiany te mogą się zmieniać wraz z upływem czasu, dlatego najlepiej użyć tylko sygnału cyfrowego.

Czy masz coś do dodania do wyjaśnienia? Dźwięk w komentarzach. Chcesz przeczytać więcej odpowiedzi od innych użytkowników Stack Exchange, którzy znają się na technologii? Sprawdź cały wątek dyskusji tutaj.